更新换代的“AIforbad”,避免上当,不做“愚人”

图片来源@视觉中国

文字 | 极体

几年前的愚人节,我们跟大家聊过人工智能技术被用作诈骗工具。 不幸的是,当时讨论的一些症状现在已经成为电子诈骗犯罪中的常用手段。

更可气的是,随着人工智能技术和应用的发展,不法分子的人工智能手段不但没有减少反而增加了。 一些“新AI”也借助这些东西的努力加入了骗人的队伍。

愚人节又到了,感觉有必要聊一聊更新后的“AI for bad”。

提高警惕,避免上当,不做“傻子”。

人们使用的AI也在更新

当我们讨论人工智能作为欺诈工具时,主要有两种技术可以应用:TTS语音合成和NLP自然语言处理。

前者通过允许犯罪分子合成假音频来工作。 2019年,华尔街日报报道称,一名骗子利用AI语音合成冒充老板,让一家分公司的总经理打电话给他22万欧元。 这种作弊现在很普遍,一开始TTS需要大量的语料来模仿,门槛比较高。 现在很多开放的TTS接口只需要10句左右的语料就可以合成语音台词,甚至可以模仿方言。 意思是防不胜防。

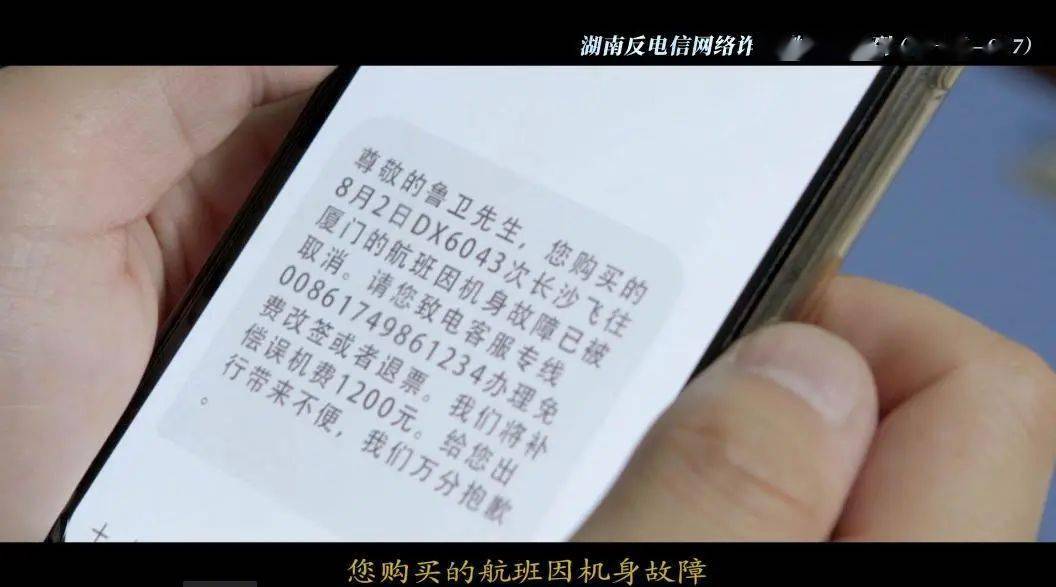

NLP技术的应用主要是针对智能手机的外呼。 我们今天接到的许多客户服务和销售电话都是由 AI 打来的。 事实上,诈骗电话也是如此。 不久前,江苏警方打掉了一个诈骗团伙。 他们利用AI智能外呼进行诈骗,数量达到了惊人的1700万。 虽然AI打诈骗电话的成功率不高,也不会像真正的骗子那样具有说服力和威慑力,但其优势在于效率高、规模大,可以被不法分子用来筛选目标或引流。

可以发现,这些技术主要是基于语音的。 但是在讨论AI诈骗手段的时候,我们说诈骗者未来肯定会往视觉方向发展。 毕竟,“眼见为实”。 如果人工智能技术可以用来伪造图片甚至视频,犯罪分子的手段就会更加多样化。 方法更微妙,AI技术本身必须向机器视觉和多模态方向发展。 骗子和AI技术,在某种程度上,供需是可以匹配的。

现在它来了! 基于视觉的人工智能骗局,恶意层出不穷!

暂且总结一下,AI作弊的第一阶段主要是语音,主要手段有:首先,合成亲戚、同事、老板的假声音进行诈骗。 二是利用AI外呼系统进行诈骗电话。 最后还有一个比较小的,就是用AI模仿手写,但是因为我国数字化程度比较高PC28有官网吗?,所以支票之类的不多,这种骗局不明显。

AI骗人的第二阶段,开始在视觉上做文章。 主要方式是通过AI制作假图片和视频。 主要技术是广为讨论的Deepfake和AIGC。

震惊歪果仁下巴的新AI骗局

2月初,叙利亚和土耳其发生强烈地震加拿大28QQ群哪里找呢?,引发全球关注。 在震后救灾工作中,人工智能技术发挥了非常关键的作用。 例如,人工智能+遥感的大量应用,有效识别了灾情,提高了救灾效率。 可以说,人工智能的运用为人类照亮了互助之光。

但也有一些人,好日子不好过,非要出来给自己丢脸。 同样在这次地震之后,全球社交媒体上出现了各种人工智能诈骗骗局,让欧美各家媒体都对人工智能技术感到了些许震撼。

例如,最著名的是一名骗子多次在推特上分享求救信息,并附上一张消防员救助儿童的照片,以及他的加密货币钱包链接。 很多不明真相的歪门邪道的人都心痛不已。 之后我立马付了钱,结果被眼尖的人发现了,为什么这张图有AIGC的味道?

后来,经过媒体的小规模调查,证实了这张以及土耳其-叙利亚地震中用于救援电话和募捐的大量其他场景图片都是AIGC生成的。 AIGC 输出量大,保真度高。 没有原图为证,伪装比较多。 配合人们灾后的焦虑和急切情绪,很容易成功实现诈骗。

土叙地震后出现的另一种诈骗形式是在TikTok等平台发布小视频,声称身处灾区利用ai声音诈骗,并号召打赏和捐款。 然而,这些视频中的背景、声音甚至人脸都可能是人工智能合成的。

由于这起事件与国际热点息息相关,引发了广泛关注和讨论,但实际上,在这场闹剧之下,利用AI+视觉技术作恶的事件并不少见。

骗子升级了,他们看到的真的是AI。

当然,这里需要说明的是,AI技术作为诈骗手段还不是主流,因为它还是有技术门槛的。 犯罪分子显然没有那么高的综合文化素养,但效率更高,隐蔽性更强。 它比我们之前对电汇欺诈和其他犯罪的理解更值得注意。

AIGC致力于杀猪

基于视觉人工智能的新型诈骗形式已经来到我们身边。 最常见的一种方法是将 AIGC 图片与杀猪结合起来。

臭名昭著的电信诈骗形式的基本思路是,电信诈骗者伪装成一个人,然后通过网上约会等方式取得被骗者的信任。 这个模型的关键之一是如何保证它不会被暴露。 毕竟,双方在沟通过程中必须要发送照片和视频。

原来杀猪的解决办法是盗取分享在各处社交媒体上的照片,一旦要视频就找理由推脱,但盗取的图片毕竟有限,而且都是“整片”,难以满足实时被骗。 请求分享照片。

最近AIGC的火爆,尤其是AI生成图片,给这些东西提供了很大的便利。 目前的人工智能图像生成软件已经可以生成几乎没有任何瑕疵的真人图片。 此外,它还可以接受服装、动作、场景设计的指令,完全可以满足杀猪拍照的需求。

你以为网恋女神会和你分享第一次在瑞士滑雪后的素颜美照,殊不知它们是刚刚在东南亚某个地下室用AI生成的。

更重要的是,一些AIGC软件可以生成边缘摩擦,甚至明显越界的图像,甚至可以生成不怎么穿衣服的视频。 这为诈骗者的裸聊诈骗增加了新的筹码。 利用真人进行裸聊诈骗,难度大,门槛高,让AI直接做是没有价值的。 一旦屏幕上的受害者被拍下作为裸聊的证据,往往是无法挽回的后果。

记得在贴吧上看到一个很火的帖子,受害者在裸聊中分享了被骗的全过程。 他的描述很痛苦,但至少他仍然相信,和他聊天的人是一个他很喜欢长相的女孩,他甚至隐约觉得,她一定是被逼的。 但他不知道的是,很可能是AI换脸加拿大28群哪里找啊?,甚至是AI生成的视频。

被骗后心疼AI,真是心酸无可争辩。

AI换脸/换装背后的猥琐“产业链”

如果说不法分子利用AIGC生成一个虚构的人来进行诈骗。 所以更可恶的是Deepfake,就是滥用AI换脸技术。 如今,各大媒体平台一致屏蔽了AI换脸等争议性内容,但这并不妨碍这项技术仍在暗中流行,甚至泛滥成灾。

不久前,一名所谓的“网红”利用AI换脸技术,合成了一段女明星与他表演吻戏的视频,进而激怒了粉丝,甚至还遭遇了物理宇宙的对峙。 对此,我想说,你真的有点活该。

还有一名女子在社交媒体上分享的照片被不法分子利用人工智能软件“一键脱衣”后在网上传播。 这一事件也引起了广泛关注。

这种侵犯他人肖像权、隐私权、名誉权的行为,就是利用Deepfake来完成的。 这种行为是极其有害的,同时,也是极度道德败坏的。 往往会导致《Keep You Safe》中散播谣言、辟谣辟谣的无奈。

与此同时,AI换脸技术也开始被应用到诈骗活动中。 比如有人利用AI换脸冒充明星,然后进行直播,诱骗粉丝打赏、刷礼物。 最近,我们可以看到很多明星工作室都在对这种行为追究法律责任。

除了AI换脸明星作弊,还有利用AI换脸冒充成熟人的骗子。 由于换脸后直接视频通话的可信度非常高,对于不懂AI技术的老年人来说可以说是防不胜防。

我们可以知道AI换脸和AI脱衣有多可怕。 但是很多人觉得AI换脸应该是一个非常难的技术,好像和影视后期制作差不多,不是一般人能做到的吧?

事实上,AI换脸已经拥有非常成熟的“产业链”,只要稍加努力就能快速学会,甚至还能获得源源不断的物质支持。 一般来说,别有用心的人想要启动AI换脸,需要解决几个问题。

首先,技术从何而来?

在GitHub等开源社区中,有一款开源的AI换脸软件。 最著名的是 Deepfacelive 和 Deepfacelab。 有很多相关的技术社区、论坛、贴吧,大量的傻瓜式学习教程,甚至还有中文版的AI换脸软件进行分发。 如果还是学不会,二手交易平台上也有大量的教程和教程出售,而且价格很低。

那么,AI换脸的图片、视频素材从何而来?

这分为两部分。 首先是普通人的图像和视频资料。 最常见的泄密渠道是社交媒体。 会有不法分子专门收集社交媒体资料利用ai声音诈骗,然后打包出售。 另一种窃取视频素材的方式是以某个名义进行视频通话,然后进行录音。 由于公安部门、银行、防疫等原因怎么找PC蛋蛋微信群平台!,往往需要进行这种视频通话。 由于不涉及货币兑换,受骗者往往没有警惕,然后骗子会利用录制的视频进行AI换脸,骗取受害人的家人和朋友钱财,或用于办理网贷。

还有一种星料。 上面提到的恶心网红可能用过所谓的“DFL灵药”给女明星进行AI换脸。 所谓“灵丹妙药”,是指利用明星视频、图片素材,进行符合DFL等软件要求的预训练。 最终模型可以直接用于人脸替换,无需训练或图像编辑。 一个明星的换脸素材库,往往只需要几十元到几百元。

现在如果你在二手交易平台上搜索“AI灵药”、“DLF灵药”等词,你会发现大量正在出售的数据模型。 买手只有两种,一种是为了满足自己的淫荡,甚至编造所谓的明星黑料; 另一种是骗子想利用名人进行网络诈骗。

不管怎样,擅自盗用一个人的肖像权和隐私权都是不可接受的。

如何防范新型AI作弊?

目前阶段,新一代AI作弊的主流方式有两种:AIGC和AI换脸。 可以预见,在生成式AI越来越强大的今天,随着AI生成视频和数字人能力的提升,这种作弊手段也将升级。

在不久的将来,可能就不需要换脸+真人了。 骗子可以直接弄个AI跟你聊天,甚至弄个假明星跟你聊天,语音合成,对话能力强大。 骗子即将实现全自动、全流程、高度智能化的人工智能诈骗。

如何防范和制止新型人工智能骗人行为,保护公众的财产权和隐私权? 至少可以从三个方面入手:

1、技术注意事项。 今天,反欺诈人工智能也得到了发展和壮大。 各平台和相关部门都在布局AI反欺诈技术能力,可谓以法治魔。 而反欺诈AI的主要逻辑是识别问题信号,进而进行AI智能外呼的主动干预。 估计在不久的将来,我们可能会看到关于欺诈 AI 和反欺诈 AI 的奇怪新闻。 然而,面对新型人工智能诈骗,人工智能反诈骗技术需要进一步升级。 比如目前有软件可以对AIGC内容进行改造识别,但受害者应该很少会想到主动识别,如果能想到,估计也不会上当。 针对视觉系统中的AI作弊,反作弊技术有待完善。

2.平台监管。 AI换脸等技术往往需要技术链来支撑。 如果能让别有用心的人无法获得软件和数据支持,那么AI换脸自然就无法泛滥成灾。 警惕不法分子利用AI做事,需要多个平台同时启动。 首先,AIGC平台必须把控内容质量,不能生成边缘化或明显不怀好意的图片和视频。 二是软件分发平台、论坛和社区。 需要对AI换脸、AI脱衣等软件流通进行管控。 禁止二手交易和本地生活平台分享销售人工智能换脸工具、明星数据灵药等内容。

3、预防意识。 要求大家提高反欺诈意识是老生常谈。 但我还是想说,我们不是在谈论被害人有罪论。 但是真的有必要做些什么吗? 很多人出于好奇或者其他的小念头,想做一个明星的换脸视频或者熟人的换脸照片。 这往往是恶行的开端PC蛋蛋靠谱群,也为更大的犯罪提供了土壤。 GHS的心理、侮辱别人的心理、盲目追星的心理,如果都淡化了,事情就会好很多。

总之,AI不会骗人,但人类会用尽一切手段来骗人。

行于世间,小心为上。

| 广告位 |